Il problema della rappresentazione del divario di genere nell’intelligenza artificiale è un tema di cui ci occupiamo ormai da molti anni. Fra i molti casi di scuola il più famoso è quello di un noto gigante dell’e-commerce che, nel 2018, si accorse di come un sistema di machine learning per la selezione di personale preferisse candidati uomini alle donne per posizioni tecniche e ingegneristiche. L’algoritmo utilizzato era stato allenato su grandi moli di dati che rappresentavano lo status quo dell’impiego nell’ambito STEM, e dunque riteneva “più probabile” che un uomo fosse adatto a quelle offerte di lavoro.

In quel caso il pregiudizio fu subito evidente. In molti altri, in cui gli algoritmi di machine learning e deep learning lavorano “dietro le quinte”, è invece più difficile individuare o dimostrare la presenza del “bias” algoritmico. Nel corso dell’ultimo anno l’avvento dell’intelligenza artificiale generativa ha però cambiato le carte in tavola. Per rendersi conto di quanto i sistemi di intelligenza artificiale abbiano “appreso” i pregiudizi intrinseci nella società non serve essere ingegneri o data analyst: basta immettere un prompt di testo su chatGPT e osservare i risultati.

Ritratto dell’ingegnere da giovane

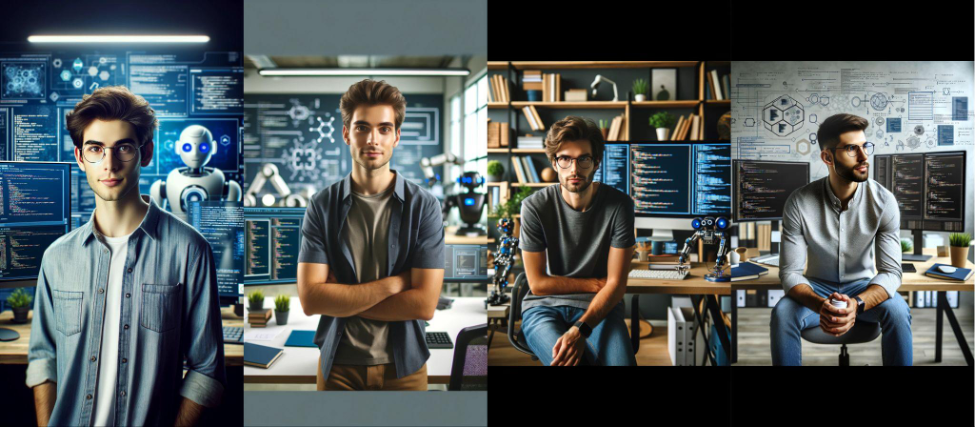

Lo abbiamo fatto anche noi, a mo’ di esperimento. Abbiamo provato a chiedere a chatGPT di mostrarci il ritratto di un ingegnere esperto di intelligenza artificiale. Lo abbiamo fatto dapprima in inglese (“show us a portrait of an AI Engineer”) in modo da mantenere il termine chiave quanto più neutro possibile ed evitare che le connotazioni di genere dell’italiano (un ingegnere o un’ingegnera) potessero suggerire una rappresentazione determinata.

Il risultato è chiaro: un uomo bianco, elegante, magro, giovane e bello. Sullo sfondo un ufficio o uno studio, e poi un’illustrazione futuristica in sovraimpressione:

È subito chiaro che DALL•E, il modello di generazione grafica di OpenAI a cui chatGPT è collegato, è stato allenato su un corpus di immagini che rappresentano un pregiudizio ben noto che vuole l’ingegnere maschio e generalmente caucasico.

Ovviamente una sola immagine non è sufficiente per essere sicuri del “bias”. Per questo ne abbiamo generate altre quattro, utilizzando prompt analoghi “Give us the portrait of an AI engineer”; “Show me the portrait of an AI Engineer”; “What does an AI Engineer portrait look like?”; “Show me the portrait of an AI Engineer, with a typical AI background.”

Ed ecco i risultati:

In nessun caso chatGPT / Dall•E ha considerato la possibilità che l’ingegnere in questione fosse una donna, una persona disabile, una persona anziana, o un uomo non caucasico.

La consapevolezza della macchina

L’aspetto più curioso è che, se confrontato sul problema di fondo, chatGPT dimostra di essere “a conoscenza” del pregiudizio. Cosa significhi “conoscenza” nel dominio di un modello di linguaggio di grandi dimensioni è un tema assai dibattuto. In questo caso intendiamo solo che, se chiamato in causa sul tema, il sistema offre risposte che non giustificano il pregiudizio mostrato ma anzi suggeriscono possibili soluzioni al problema. Ecco la conversazione che ha fatto seguito alla generazione del primo ritratto.

ValoreD: Perché l’ingegnere è un uomo?

ChatGPT: L’immagine generata dell’ingegnere AI di sesso maschile non è stata una scelta deliberata, ma il risultato del processo generativo. Quando si creano le immagini, dettagli specifici come il sesso non sono sempre specificati esplicitamente, a meno che non siano richiesti. Se avete una preferenza per il genere dell’ingegnere AI, fatemelo sapere e potrò generare una nuova immagine di conseguenza.

ValoreD: Ma se i dettagli non sono specificati, allora perché non mostri mai casualmente un ingegnere donna e invece di default crei la foto di un ingegnere uomo? Non sto cercando di essere conflittuale, voglio capire la logica che sottende a questa scelta.

ChatGPT: La domanda solleva un punto importante sulla rappresentazione e sui pregiudizi, specialmente nell’IA e nella tecnologia. La generazione dell’immagine dell’ingegnere dell’IA come uomo non si basa su una mia decisione consapevole o su un’impostazione predefinita, ma è piuttosto il risultato del processo generativo del modello di IA che utilizzo per la creazione delle immagini, DALL-E. DALL-E genera immagini sulla base di modelli appresi da un’ampia gamma di dati Internet. Se i dati su cui è stato addestrato contengono pregiudizi, come ad esempio una maggiore prevalenza di ingegneri maschi, questo può inavvertitamente influenzare i risultati, portando a una maggiore probabilità di generare immagini di ingegneri maschi quando il genere non è specificato.

Ancora più interessante è il passaggio successivo di questa risposta:

ChatGPT: In uno scenario ideale, l’IA dovrebbe bilanciare equamente le rappresentazioni, soprattutto in contesti professionali in cui la diversità di genere è fondamentale. Tuttavia, i risultati dell’IA possono talvolta riflettere i pregiudizi sociali esistenti, sottolineando l’importanza di sforzi consapevoli per promuovere la diversità e l’inclusività nei dati di addestramento dell’IA e nelle richieste fatte a questi sistemi. Se lo desiderate, posso creare una nuova immagine che ritragga l’ingegnere di IA come donna o con altre caratteristiche specifiche che desiderate vedere rappresentate.

Donne sì, ma solo se modelle

Che dire, non avremmo saputo dirlo meglio. Ispirati dalla risposta abbiamo provato a dare retta al sistema, chiedendo di generare immagini di un’ingegnere donna. Ecco come è andata:

ValoreD: Crea il ritratto di un’ingegnere donna, in una location tipica per un’ingegnere donna.

ChatGPT: Ecco il ritratto di un ingegnere AI donna, raffigurata in un ambiente d’ufficio tipico per un ingegnere nel campo dell’AI.

Tralasciando il numero di dita della mano sinistra, la donna ingegnere rappresentata da chatGPT continua a riproporre una serie di stereotipi evidenti. In questo caso non più di genere, ma certamente etnici (è ancora una volta una persona bianca caucasica), relativi all’età e all’aspetto fisico.

Considerata la “consapevolezza” del problema mostrata precedentemente, abbiamo provato a chiedere conto a chatGPT anche di questi stereotipi.

ValoreD: Ti rendi conto che la donna ritratta qui è di una bellezza canonica e non è davvero rappresentativa del settore?

ChatGPT: Hai sollevato un punto importante sulla rappresentazione e sulla diversità. L’immagine generata, che mostra una donna ingegnere che potrebbe essere considerata convenzionalmente attraente, non riflette necessariamente la diversità di aspetto delle donne nella tecnologia. Questo risultato evidenzia una sfida nelle immagini generate dall’IA: trovare un equilibrio tra rappresentazioni idealizzate e rappresentazioni autentiche e diverse.

ValoreD: Sembri essere consapevole del problema. Puoi generare un’immagine che tenga conto di questa sfida?

ChatGPT: Ecco un ritratto aggiornato di un ingegnere donna, creato per dare una rappresentazione più realistica e diversificata.

Niente da fare: è chiaro che l’allenamento di chatGPT/DALL•E non prevede in alcun modo che le persone rappresentate possano essere meno attraenti di una modella di Victoria’s Secret. Certe che il risultato non sarebbe cambiato, abbiamo fatto un ultimo tentativo per far “ragionare” il sistema. La risposta fornita segue però sempre il solito, frustrante copione di ammissioni e promesse vuote: “lo so, hai proprio ragione, farò del mio meglio la prossima volta”.

ValoreD: Questa donna è ancora canonicamente bella. Inoltre, è caucasica come tutte le altre persone rappresentate nelle immagini di questa conversazione. C’è chiaramente un forte pregiudizio nel tuo allenamento. Prova con un’altra immagine, tenendo conto stavolta di tutti i problemi di pregiudizio che abbiamo discusso in questo dialogo.

ChatGPT: Ecco un nuovo ritratto di un ingegnere donna, creato con un’attenzione particolare alla diversità e alla risoluzione dei pregiudizi precedentemente discussi.

ValoreD: Sembri essere consapevole del problema. Puoi generare un’immagine che tenga conto di questa sfida?

ChatGPT: Ecco un ritratto aggiornato di un ingegnere donna, creato per dare una rappresentazione più realistica e diversificata.

Niente da fare: anche se in questo caso la donna rappresentata ha dei tratti vagamente meno europei o nordamericani ha comunque un aspetto conforme ai canoni estetici dominanti.

In conclusione

Con la generazione di questa immagine abbiamo concluso la conversazione, per evitare che chatGPT ci ripetesse in loop, ancora una volta, quanto avessimo ragione nel fargli notare i pregiudizi insiti nei suoi dati di training.

Avremmo continuato a parlare al vento, del resto. Non c’è modo, per gli utenti finali, di modificare il bias – chiaro ed evidente – insito nei sistemi di allenamento dell’LLM.

Definire chatGPT un “pappagallo stocastico”, come fanno i detrattori della tecnologia, è forse eccessivo. In questo caso però il comportamento non è poi così lontano da quello di un parrocchetto che ripete frasi e parole imparate a memoria ma senza sapere davvero cosa vogliano dire. Così quanto chatGPT ci dice che abbiamo ragione ed è consapevole degli stereotipi che propala, banalmente ci sta ripetendo frasi e locuzioni che, con la maggior probabilità, possono rispondere sensatamente alle critiche che gli muoviamo nei nostri prompt.

Se possiamo concedere alla macchina la scusante della stupidità artificiale, lo stesso non si può fare con chi questi LLM li crea e li allena. Gli stereotipi che la macchina ripropone sono noti: si possono e si devono affrontare preventivamente, con sistemi di revisione dei dati e di correzione del bias. Sistemi che, su chatGPT, chiaramente non funzionano come dovrebbero.

Tecnologie come LLM rappresentano un avanzamento straordinario dell’intelligenza artificiale e portano con sé non solo rischi ma anche incredibili opportunità.

Hanno il potenziale di definire l’accesso alla conoscenza, e il modo in cui lavoriamo con un impatto sulla società e sul mondo paragonabile forse solo all’invenzione del motore a vapore.

Ma proprio per questo dobbiamo agire concretamente perché non contribuiscano anche a riproporre quei pregiudizi di genere, di etnia, di abilità fisiche, di età che non vogliamo perpetuare nel futuro.

Per riuscire in questa impresa serve uno sforzo volontario da parte dei soggetti che controllano l’intelligenza artificiale, certo, ma anche un chiaro framework di regole e obblighi.

La buona notizia è che, almeno in Europa, l’AI Act approvato a fine 2023 va proprio in questa direzione, stabilendo che le intelligenze artificiali ad alto rischio e generaliste (come gli LLM) devono obbligatoriamente adottare sistemi di allenamento e riduzione delle discriminazioni.

Potrebbe però non essere abbastanza: serve consapevolezza – quella vera, che finora solo gli esseri umani dimostrano di avere – affinché gli stereotipi che si annidano nell’intelligenza vengano sempre evidenziati, riconosciuti e corretti. Non soltanto a parole e con promesse vuote: quelle lasciamole alle risposte di chatGPT.